vue

sqlserver

JUC

压力测试

web大作业

类型转换

Tableau Desktop

注释

protobuf

进程同步

软考高级系统架构设计师系列

salesforce

基本指令

symfony

pthread

CalBioreagents

three.js

Junit使用的基本流程

因数平方和

fiddler

模型蒸馏

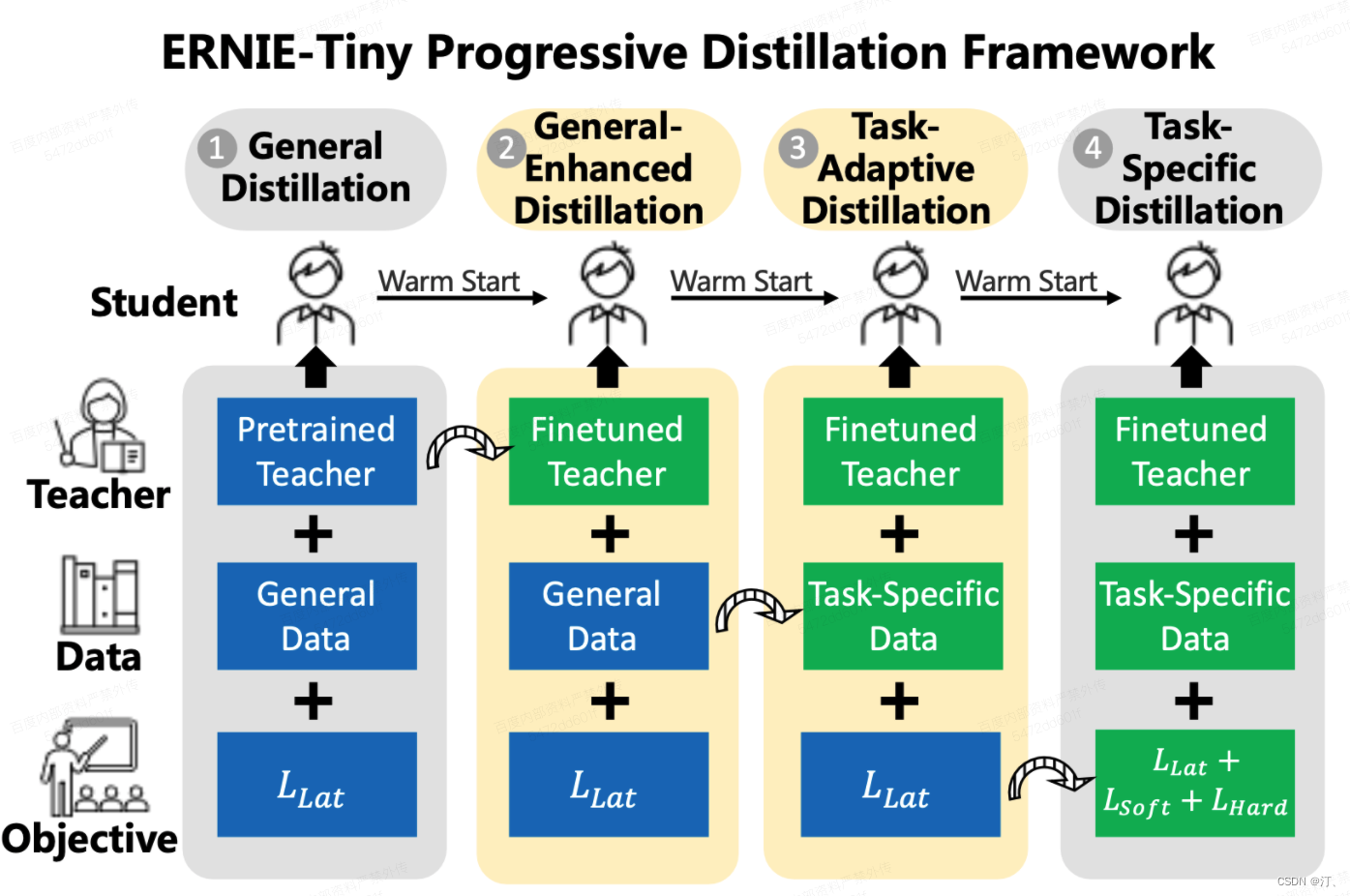

2024/4/11 14:55:02知识蒸馏相关技术【模型蒸馏、数据蒸馏】以ERNIE-Tiny为例

1.任务简介

基于ERNIE预训练模型效果上达到业界领先,但是由于模型比较大,预测性能可能无法满足上线需求。 直接使用ERNIE-Tiny系列轻量模型fine-tune,效果可能不够理想。如果采用数据蒸馏策略,又需要提供海量未标注数据ÿ…

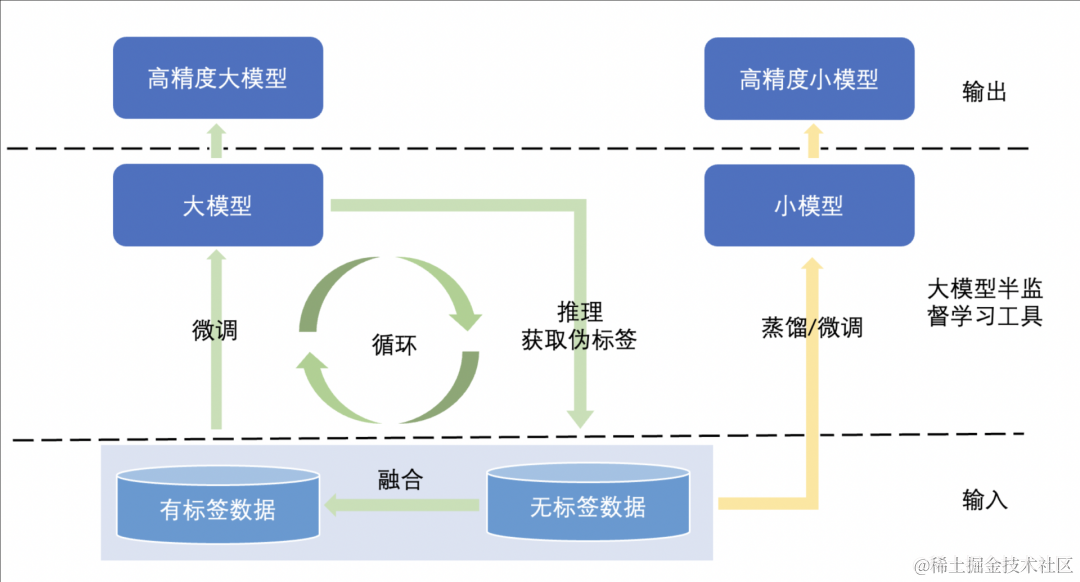

提效神器!10%标注数据,比肩全量标注的模型效果!

不知道大家有没有遇到过数据标注成本高、周期长的困扰,有没有那么一种可能,精心标注少量的数据,配合大量的无标注数据,就能达到比肩全量标注的模型精度呢?是的,PaddleX就带来了这样一款提效神器——大模型半…

BERT等复杂深度学习模型加速推理方法——模型蒸馏

参考《Distilling the Knowledge in a Neural Network》Hinton等

蒸馏的作用

首先,什么是蒸馏,可以做什么?

正常来说,越复杂的深度学习网络,例如大名鼎鼎的BERT,其拟合效果越好,但伴随着推理…

[论文笔记]MobileBERT

引言

今天带来一篇关于量化的论文MobileBERT,题目翻译过来是:一种适用于资源有限设备的紧凑型任务无关BERT模型。模型的简称是MobileBERT,意思是作者的这个BERT模型可以部署到手机端。

本篇工作,作者提出了MobileBERT用于压缩和加速BERT模型。与原始BERT一样,MobileBERT…

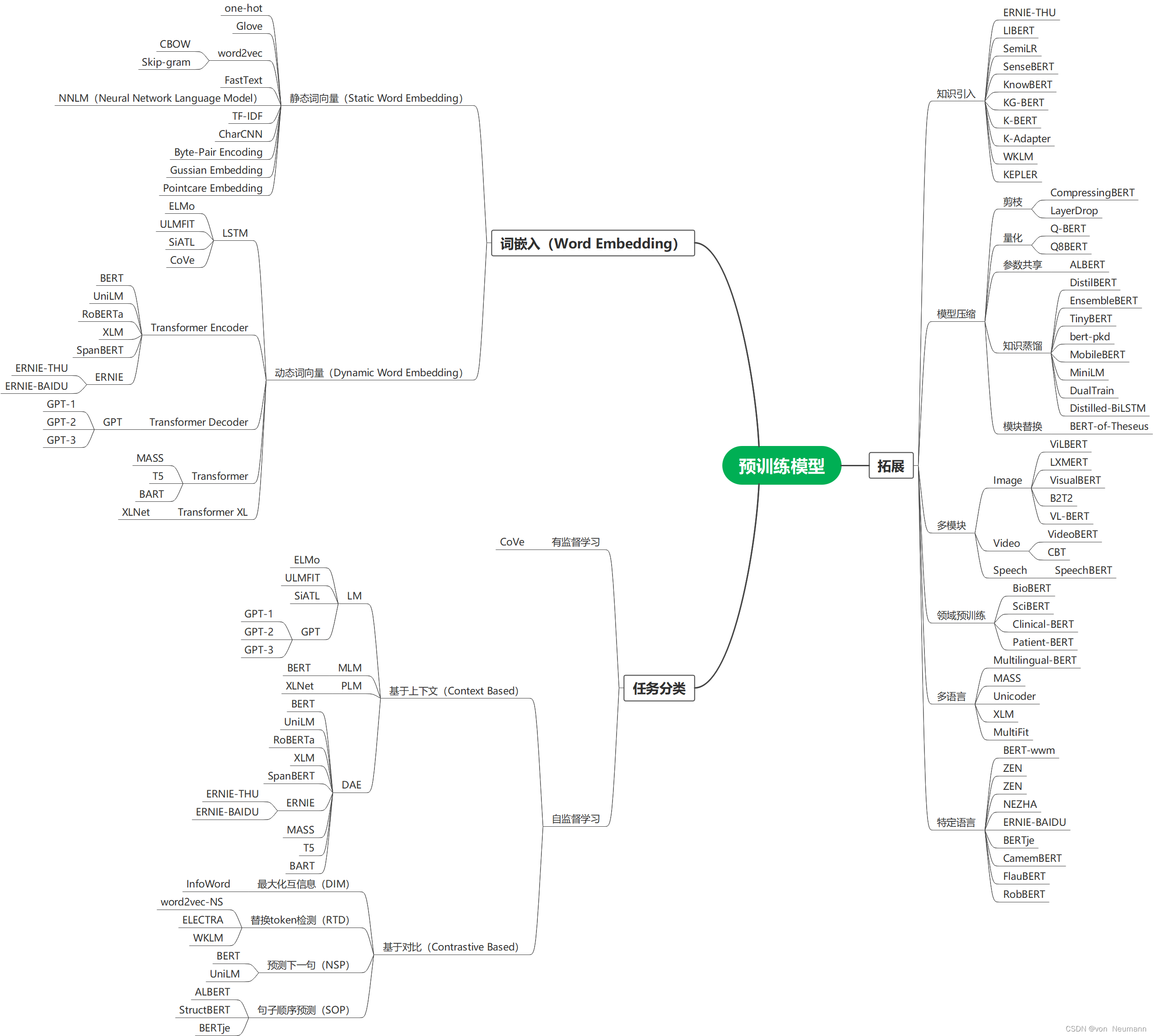

自然语言处理从入门到应用——预训练模型总览:预训练模型的拓展

分类目录:《自然语言处理从入门到应用》总目录 从大量无标注数据中进行预训练使许多自然语言处理任务获得显著的性能提升。总的来看,预训练模型的优势包括:

在庞大的无标注数据上进行预训练可以获取更通用的语言表示,并有利于下游…

知识蒸馏博客阅读与理解学习

如何理解soft target这一做法? - YJango的回答 - 知乎 https://www.zhihu.com/question/50519680/answer/136406661

1. 是什么 2. 温度的作用

2.1 概述

2.2 举例 知识蒸馏:深入理解温度的作用 https://blog.csdn.net/weixin_39078049/article/detail…

nlp bert 模型蒸馏大全和工具

1. 各种蒸馏方案大全 2. 蒸馏工具

https://github.com/airaria/TextBrewer#quickstart

2.1 蒸馏步骤: 2.2. 方法:看起来比较简单

import textbrewer

from textbrewer import GeneralDistiller

from textbrewer import TrainingConfig, DistillationCo…

Distilling the Knowledge in a Neural Network

论文地址

1. 学习记录 看完之后再看这个也不错: 论文笔记 《Distilling the Knowledge in a Neural Network》:https://luofanghao.github.io/blog/2016/07/20/%E8%AE%BA%E6%96%87%E7%AC%94%E8%AE%B0%20%E3%80%8ADistilling%20the%20Knowledge%20in%20a…

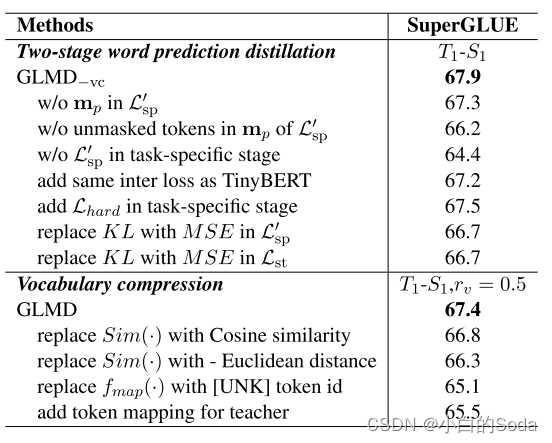

通用语言模型蒸馏-GLMD

文章目录 GLMD一、PPT内容论文背景P1 BackgroundP2 Approach 相关知识P3 知识蒸馏P4 语言建模词预测逻辑 方法P5 两阶段词汇预测蒸馏P6P7 词汇压缩 实验结果P8 results 二、论文泛读2.1 论文要解决什么问题?2.2 论文采用了什么方法?2.4 论文达到什么效果…